晶圆级技术再次掀起波澜,有望使拥有数万亿参数的人工智能 (AI) 模型比传统的基于 GPU 的系统运行得更快、更高效。加州大学河滨分校 (UCR) 的工程师声称,他们开发出了一种飞盘大小的芯片,可以传输海量数据,且不会过热或耗电。

他们将这些巨型芯片称为晶圆级加速器,Cerebras 在餐盘大小的硅晶圆上制造这些芯片。这些晶圆级处理器能够提供更强大的计算能力和更高的能效,随着 AI 模型规模不断扩大、要求越来越高,这些特性至关重要。

餐盘大小的硅晶片与邮票大小的 GPU 形成鲜明对比,后者现在被认为是人工智能设计中的必需品,因为它们可以并行执行多项计算任务,例如处理图像、语言和数据流。

然而,随着人工智能模型复杂性的增加,即使是高端 GPU 也开始达到性能和能量极限,加州大学河滨分校伯恩斯工程学院电气与计算机工程教授、发表在《设备》杂志上的论文的主要作者 Mihri Ozkan 表示。

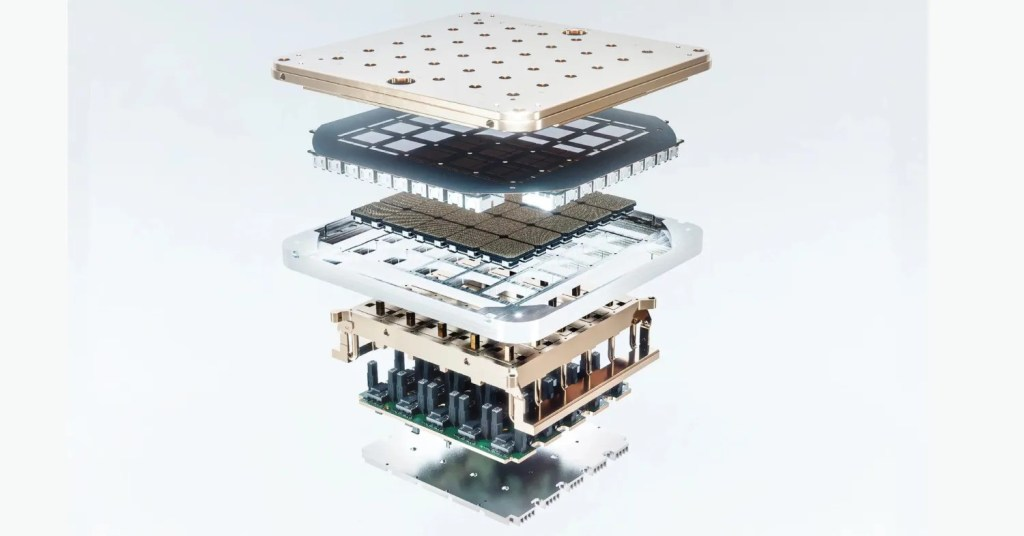

图1: Cerebras 制造的晶圆级引擎 3 (WSE-3) 避免了芯片间通信带来的延迟和功率损耗。资料来源:加州大学河滨分校

“人工智能计算不再仅仅关乎速度,”Ozkan补充道。“它关乎设计能够传输海量数据而不会过热或消耗过多电力的系统。”他将GPU比作繁忙的高速公路,高速公路高效运行,但交通拥堵会浪费能源。“晶圆级引擎更像是单轨列车:直接、高效、污染更少。”

由加州大学河滨分校 (UCR) 工程师开发的 Cerebras 晶圆级引擎 3 (WSE-3),在单个晶圆上集成了 4 万亿个晶体管和 90 万个 AI 专用核心。此外,据 Cerebras 报告,WSE-3 系统上的推理工作负载仅消耗同等 GPU 云设置六分之一的功耗。

还有特斯拉的Dojo D1,这是另一款晶圆级加速器,每个模块包含1.25万亿个晶体管和近9000个核心。这些晶圆级芯片的设计旨在消除数据在多个较小芯片之间传输时出现的性能瓶颈。

图2: 2021年发布的Dojo D1芯片旨在增强全自动驾驶和自动驾驶系统。来源:特斯拉

然而,正如加州大学河滨分校的奥兹坎所承认的,散热仍然是一个挑战。由于热设计功率高达 10,000 瓦,晶圆级芯片需要先进的冷却技术。在这方面,Cerebras 使用内置于芯片封装中的乙二醇基回路,而特斯拉则采用了一种冷却液系统,将液体均匀分布在芯片表面。

(原文:Wafer-scale chip claims to offer GPU alternative for AI models,by Majeed Ahmad)

最前沿的电子设计资讯

最前沿的电子设计资讯