进入新千年的这18年中,发生了一系列令人振奋的电子创新,其中包括专为工业(特别是智能工厂)应用而开发的“智能”机器人。

5G通信的出现将使工厂能够从生产车间获取数据,从而改善质量并提高自动化程度。5G低延迟、加快的边缘计算以及快速采样能力等,都将提高制造速度,并实现制造零部件的闭环在线检测。

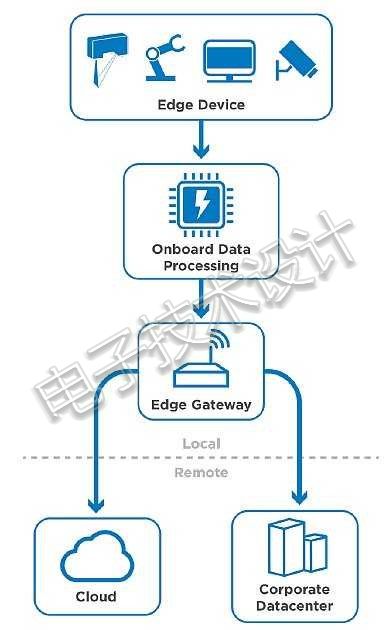

据慧与(HPE)称,“边缘计算是一种分布、开放的IT架构,具有分散式处理能力,可支持移动计算和物联网(IoT)技术。在边缘计算中,设备本身可以处理数据,或通过本地计算机或服务器来处理数据,而不必传输到数据中心(图1)。

图1:加速的数据处理推进到在边缘设备上完成。(图片来源:《Trends in 3D Inspection: Edge Computing, Acceleration, and 3D Smart Sensors for IIoT》)

智能机器人性能的一个关键组成部分就是机器视觉(MV)技术,这是计算机与高速摄像头的完美结合。通过结合这两种技术,就可以执行复杂的检查任务及数字图像采集和分析。这些数据可以用来控制机器人手臂、对物体进行分类、对图案进行识别,以及很多我们尚未想到的事情。

首先,我们要从嵌入式视觉联盟(Embedded Vision Alliance)谈起,它将嵌入式视觉定义为将计算机视觉应用在机器上,而使其能够通过视觉手段来了解周围环境。

接下来,我们来看一下机器人视觉传感架构的工业应用。机器视觉最佳和最复杂的一个方面就是3D成像。摄像头与其他支持设备相结合,可执行许多任务,包括图像信号处理(ISP)、视频传输、格式转换、压缩和分析等。

随后我们介绍一些来自微软、英特尔和Occipital的3D摄像头成像技术。

微软Azure通过云计算提供了一个简洁的计算机视觉产品。他们通过这一平台为机器人带来了智能优势。该公司官网上有一个示例可以说明他们是如何分析图像的。其计算机视觉API非常引人注目。Jabil Circuit公司是他们的一个客户,已经将其工厂车间连接到云端,从《From the factory floor to the cloud: integrating predictive analytics with real-time manufacturing》一文中可以了解到他们如何将预测性分析与实时制造相结合。Jabil在其制造中采用了传感器、无线通信、精密机器、光学、自动化和机电一体化等技术。

在2018年末,微软宣布与Open Robotics和ROS工业联盟(ROS-I)合作,将机器人操作系统(ROS)引入Windows 10。

英特尔采用硬件方法来加速智能视觉的开发,即通过基于FPGA的加速器解决方案技术(归功于其2015年收购Altera),结合英特尔CPU,开发下一代视觉系统。

摄像头传感器技术正在不断改进,因此有一种趋势是用智能互联网协议(IP)摄像头来取代模拟摄像头。此外,在与IP摄像头的新组合中,还有基于人工智能(AI)深度学习的视频分析。FPGA特别适用于基于视觉的系统,因为它具有高性能功耗比、低延迟和灵活性等优点(图2)。

图2:FPGA具有支持不同传感器和机器视觉接口的灵活性。(图片由英特尔提供)

由于FPGA可以使用不同的图像传感器和机器视觉专用接口实现机器视觉摄像头设计,因此机器视觉技术可通过使用其来得到增强。FPGA还可用作边缘计算平台中的视觉处理加速器,借助人工智能深度学习功能来分析机器视觉数据输出。

可在机器人视觉摄像头中使用FPGA来增强和实现的其他领域包括:多个千兆以太网(GigE)摄像头的使用,其中FPGA可以集成图像捕获、摄像头接口、通信和预处理等;在机器视觉摄像头和运行算法的主机之间建立帧抓取器链路;利用TI的Channel Link接口实现Camera Link的使用;USB 3视觉;CoaxPress;以及Thunderbolt等。

Occipital这家公司面向机器视觉的Occipital Tracking技术,具有6自由度(6-DoF)位置跟踪、绘图和障碍物感知等功能。他们还有Structure传感器和Structure Core等产品可用于机器人系统。

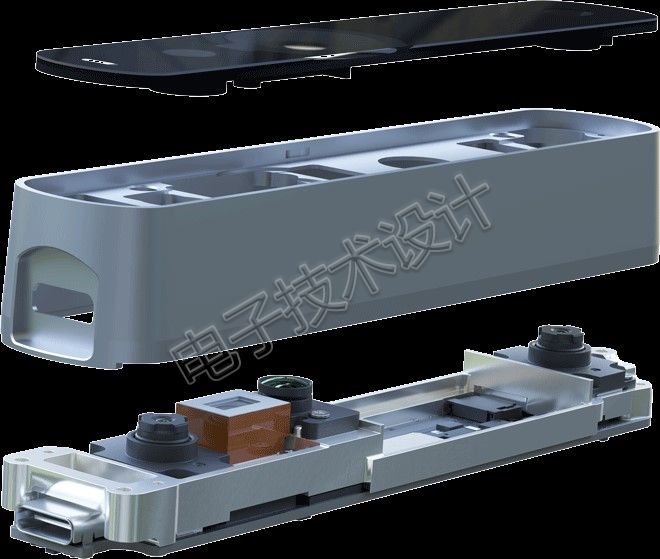

Occipital利用Structure Core设计了一个袖珍型计算机视觉设备,具有板载广角摄像头、立体红外功能、板载DSP,以及彩色模块。图3显示了三个摄像头:一个160度视场角的广角摄像头和两个红外摄像头。它还有一个板载惯性测量单元(IMU),以及一个用于计算深度并也具有可编程DSP的NU3000处理器。

图3:Occipital Structure Core是一种高级深度传感器。(图片由Occipital提供)

康耐视(Cognex)公司提供3D激光轮廓仪解决方案,例如3D位移传感器可用于产品的3D检测(图4)。

图4:康耐视DS1000和DS925B 3D激光位移传感器。(图片由Cognex提供)

康耐视还拥有基于VISIONPRO VIDI深度学习的软件,可用于工厂自动化应用中的工业图像分析。该软件结合了人工智能(AI)、VisionPro和Cognex Designer软件,可以处理缺陷检测、纹理和材料分类、装配验证、变形零件定位,以及字符读取,包括失真打印。

接下来,我们将从设计人员角度考察一些半导体专家,了解它们可以为定制和/或专有硬软件设计提供哪种解决方案。

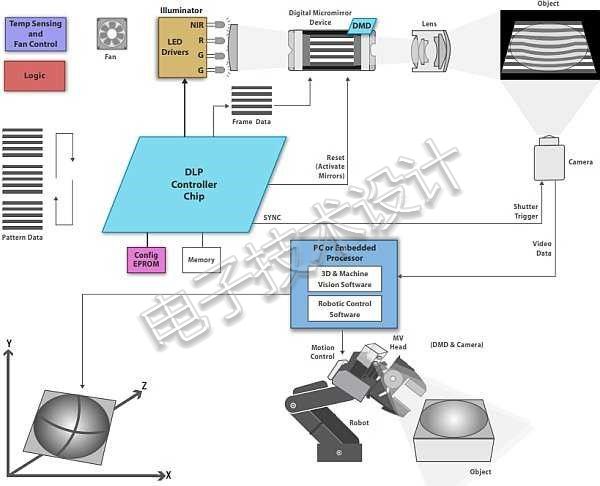

TI为机器视觉摄像头提供了一些非常不错的参考设计。TI为3D机器视觉提供的一种独特的解决方案,利用了其数字光处理器(DLP)技术。通过图5中的例子可以看到,如何可以在3D机器视觉应用中利用DLP。

图5:面向3D机器视觉的DLP解决方案。

除硬件外,TI还提供DLP结构光软件开发套件(SDK),以及基于其TIDA-00254的3D机器视觉完整参考设计。

ADI公司选择为条形码扫描仪开发解决方案。机器视觉系统设计因为需要识别和读取大量的各类标签,而无论其大小、形状、颜色或条件如何,所以需要使用这类基于图像的系统。他们认为条形码扫描仪市场目前正在从基于激光的系统转向成像解决方案,从而获得更高的扫描分辨率、吞吐量和专一性。为此,嵌入式处理器需要进行边缘检测与分类,腐蚀、膨胀、重定位和感兴趣区域选择,以及扫描算法包含颜色和模板匹配部分。

在机器视觉摄像头领域,要求摄像头本身就能实时检测缺陷或异常,Blackfin DSP的分析处理功能可以提高效率,并提供更具成本效益的线扫描和故障检测解决方案。

ADI公司还推出了一款六足蜘蛛机器人,它可以部署在对人类来说过于危险的恶劣环境中,例如地震或其他自然灾害地区。

机器人将在智能工厂和太空中与人类一起工作。这类协作机器人被称为cobot。计算机视觉和图像识别的新技术进步,将帮助这些cobot避免与其人类同事相接触。VEO Robotics是一家为工业cobot开发感知和智能方案的公司典范。

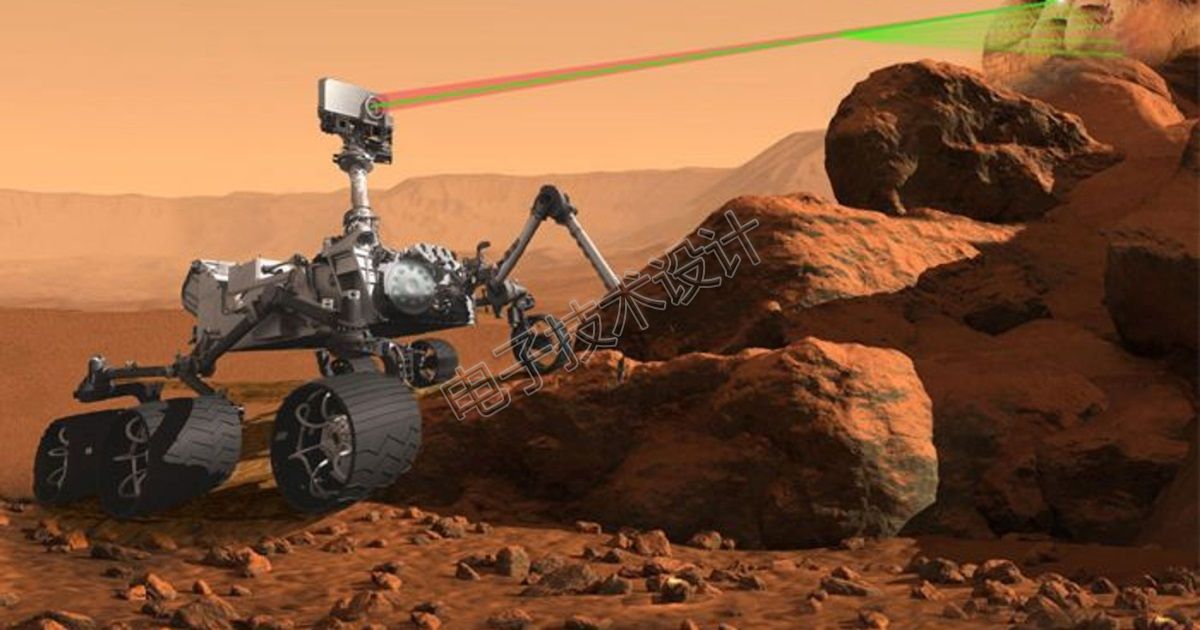

现在我们来看看NASA用于自动漫游车的机器视觉技术。最新的火星漫游车是Mars 2020 Rover,它有一个非常独特的“SuperCam”——不像大多数其他机器视觉摄像头那样看图像,而是使用红外和绿色激光束来远程分析土壤和岩石等材料的化学成分。使用的技术是激光诱导击穿光谱法(LIBS),利用漫游车上的远程RAMAN光谱系统进行矿物分析(图6)。欲了解更多信息,可参阅文章《‘SuperCam’ Update: Multi-purpose Instrument Coming Together for 2020 Launch to Mars》。

图6:Mars 2020 Rover使用SuperCam。(图片由NASA提供)

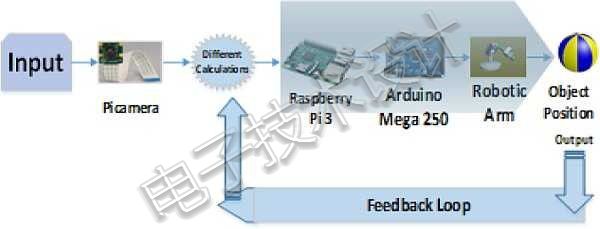

AI正在成功地应用于计算机视觉系统,特别是机器人视觉。计算机视觉(CV)可以获取、分析、处理和理解图像。《Computer Vision Based Object Grasping 6DoF Robotic Arm Using Picamera》一文中给出了基本的机械手设计,它可以在特定位置执行起吊、运输和卸放物体等多种任务。这个机械手与基于摄像头的3D视觉系统相配合——该系统连接到一台具有视觉算法功能的计算机,能够识别物体的变形以及空间协调,从而使机械手能够遵循特定程序来完成其任务。

这种机器人设计使用了Picamera——这是一款官方的Raspberry Pi产品,能够拍摄照片、录制视频,并可将所用图像特效用作输入(图7)。

图7:系统框图。(图片来自《Computer Vision Based Object Grasping 6DoF Robotic Arm Using Picamera》)

这个系统设计使用了两种算法:算法1用于识别红色物体,而算法2可在将物体位置与机械手手爪位置进行比较时,与机械手一起识别物体位置。

这是初学者学习机器视觉或计算机视觉和机器人技术的一个相对基础的例子。这个示例通过将机械手的所有轴聚焦到所需对象来执行一些不同的基本功能,并可在所需位置对其卸放。

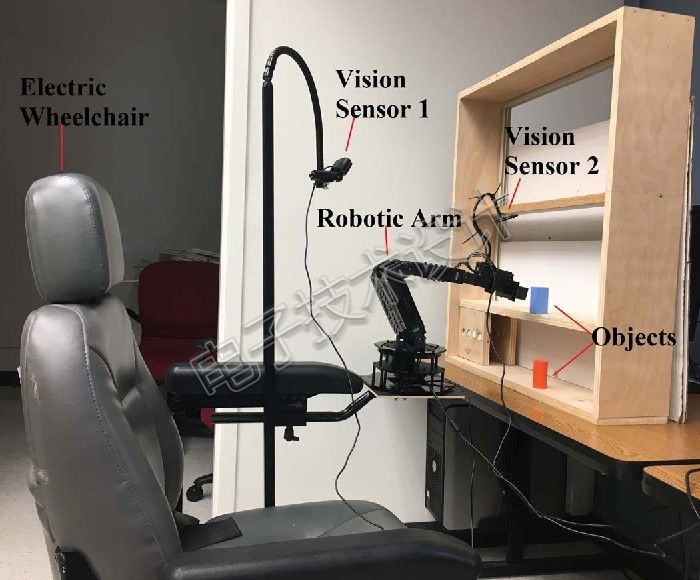

这个例子比前一个例子复杂一点。该设计将帮助患有医疗运动障碍的患者执行日常任务。由于患有上肢肢体疾病(如帕金森病)的患者手动控制机械手会比较困难,因此这种设计可以使他们受益。将使用计算机视觉的自主手臂安装在轮椅上是基本的思路。

机械手具有六个自由度,并结合计算机系统和两个视觉传感器安装在电动轮椅上。一个传感器使用计算机视觉算法,检测架子上随机所放有色物体的粗略位置。第二个传感器通过确保物体准确放在手爪前来给出物体的精确位置。手臂将自动抓取有色物体,并将其交给用户(图8)。

图8:安装在电动轮椅上的机械手。(图片来自《Automation of a Wheelchair Mounted Robotic Arm using Computer Vision Interface》)

这种机械手是由Trossen Robotics公司开发的PhantomX Reactor机械手套件。它使用的Arbotix-M机器人控制器是由Trossen自己开发——这款微控制器与Arduino兼容。为了通过计算机与手臂通信,设计人员使用了python串口访问库PySerial。

两个USB网络摄像头视觉传感器用于物体检测。视觉传感器1是罗技HD c920网络摄像头,安装在面向架子的机械手上方。这样可以捕获手臂和架子的视频以便进行实时的粗略定位,通过对视频帧进行处理即可定位目标对象的X和Y位置。视觉传感器2是一个机器人VGA网络摄像头,使用200mm鹅颈管安装在手爪上方。这一视觉传感器用来捕获目标物体的近距离特写视频。计算机视觉算法负责寻找并抓住对象物体,并将其拿到用户面前,交给用户。

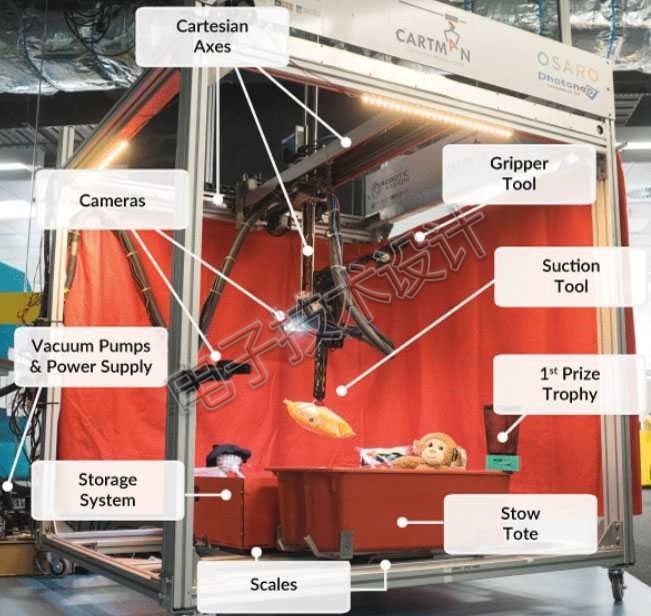

澳大利亚机器人视觉中心(ACRV)团队成功设计了一款用于自动仓储的取放机器人,而赢得了2018年亚马逊机器人挑战赛冠军。这款笛卡尔机器人名叫Cartman。

对于机器人来说,从杂乱的随机物体堆中选择一件特定物体是比较困难的事。这个项目则更加先进,可以用于家庭清洁,或先进的空间相关样品退还任务。图9显示了Cartman的组成部分。

图9:Cartman设计有两个6自由度机械手。其手腕上安装有一个摄像头以及两个效应器工具(抽吸工具和平行夹持机构)。框架上安装了第二个摄像头,对红色背景幕布区域的物品拾取进行二次摄像。(图片来自《Cartman: The low-cost Cartesian Manipulator that won the Amazon Robotics Challenge》)

由于要安装在机器人的手腕上,英特尔RealSense SR300 RGB-D摄像头因其体积小和重量轻等优点而被选中。这款摄像头使用摄像头中的红外线投影仪来确定深度。另一个RealSense摄像头安装在机器人的框架上,用于对所拾取的物品进行第二次分类检查。

这次比赛中一个有趣的挑战是,机器人要拾取的物品仅在每次竞赛开始前45分钟才提供给参赛团队。这为深度学习带来了挑战。这个获奖团队选择在一组最小的未见物品数据上微调其基础RefineNet网络。该团队开发了一个半自动数据收集流程,而使他们能够收集到每个未见物品七个独特姿势的图像数据,并创建带标记的数据集,从而在7分钟内对网络进行微调。在比赛期间,微调是在Intel Core i5-7600电脑和四块NVIDIA GTX1080Ti显卡上进行的。

从挑战赛可以看出,该团队意识到,机器人系统的性能仍然有很长的路要走,才能达到人类的水平(人类可以做到大约400次拾取/小时,而Cartman只能执行大约120次/小时)。他们认为以下两个特性对于赢得挑战比赛至关重要,对设计能够在现实世界中使用的自动机器人系统同样重要:

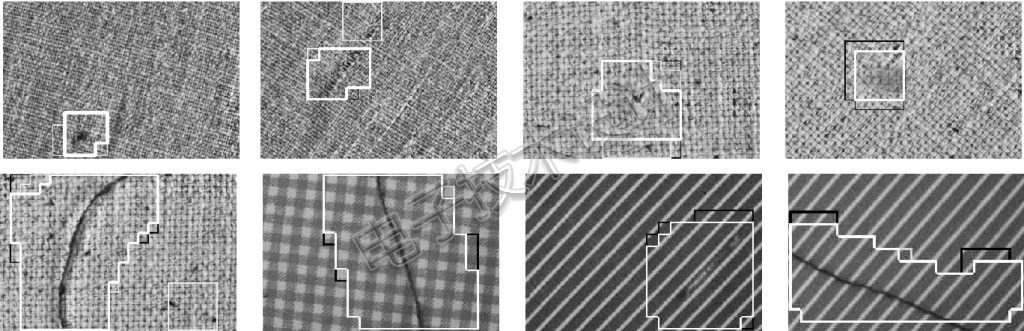

Teledyne Dalsa拥有不错的区域扫描、线扫描、TDI线扫描、智能和红外摄像头系列。他们已经接受了在要求苛刻的纺织行业中使用机器视觉的挑战,即要求成品不能有结构性和表面缺陷。这是一项艰巨而复杂的任务。

机器视觉主要用于恶劣工业环境中的工业摄像头。在纺织行业,生产线可能每天24小时运作,材料又可能在这样的生产线上以高达120米/分钟的速度移动,同时要求保持产品有高度的一致性和质量,这样才能提高效率和利润。

这种工作中所采用的摄像头通常是线扫描摄像头,其单行像素可用于对快速移动材料创建连续的2D图像。这些摄像头特别适用于连续布料成像,同时可以检测出图案、颜色和纹理的变化,以及材料中的缺陷。与面扫描摄像头相比,这类摄像头在提供高速无渍图像方面表现出色,具有很好的处理效率和更低的每像素成本。

较新的多线扫描摄像头与不同的LED光源相结合,可以检测沿生产线快速移动的纺织品在整个长度和宽度上的一系列缺陷。整个视场角范围内的照明应该是均匀并且高密度的。

图10:检测结构性缺陷。(图片来自《A New Look: How Machine Vision Is Changing Textile Inspection》)

参考文献《A New Look: How Machine Vision Is Changing Textile Inspection》中指出,“线扫描摄像头生成的数据通常用于创建二维图像,或自动创建一张图,用来准确显示缺陷位于纺织品表面的位置。质量控制检验员可以查看这张缺陷图来确定其有效性。质量控制检验员所寻找的一些典型缺陷包括水损坏、印刷错误、异物纤维、油斑等。然后,图像处理软件对图像或缺陷图进行分析,来对所检测纺织品构建虚拟切割方案。这个过程可使制造商在实际切割纺织品之前虚拟地构建一个切割方案,从而能够以最小的缺陷达到最大产量。一旦生成了理想的切割方案之后,制造商就可以据此实施,并准备纺织品的发货了。”

机器人在与我们一起工作,它们可以看到许多人类无法看到的东西,处理大量数据的速度要比人类大脑快几个数量级。他们有眼睛、耳朵、语音,以及嗅觉和感觉能力。他们可以走路、交谈、抓取,并执行复杂的功能。我们正在进入人工智能的时代,这是机器人推理的开始。但我们是这项技术的创造者和主人,有责任确保我们的创造用于正当目的,同时需要重新培训可能因先进技术而失去工作的人。技术是好的,但我们作为技术的监护者,必须保持它们在社会中的地位,同时确保为每个人创造更美好和更成功的世界。

最前沿的电子设计资讯

最前沿的电子设计资讯