辅助驾驶技术正从基于规则和模块化的传统范式,迈向由视觉语言模型(VLM)和视觉-语言-动作模型(VLA)驱动的新阶段。

● VLM作为车辆的“认知核心”,通过统一处理多模态感知数据和自然语言信息,使车辆能够理解复杂的交通场景、遵守抽象的交通规则并响应人类指令。

● VLA则在VLM的理解基础上,深度融合感知、理解与车辆控制,实现端到端、拟人化的驾驶行为。

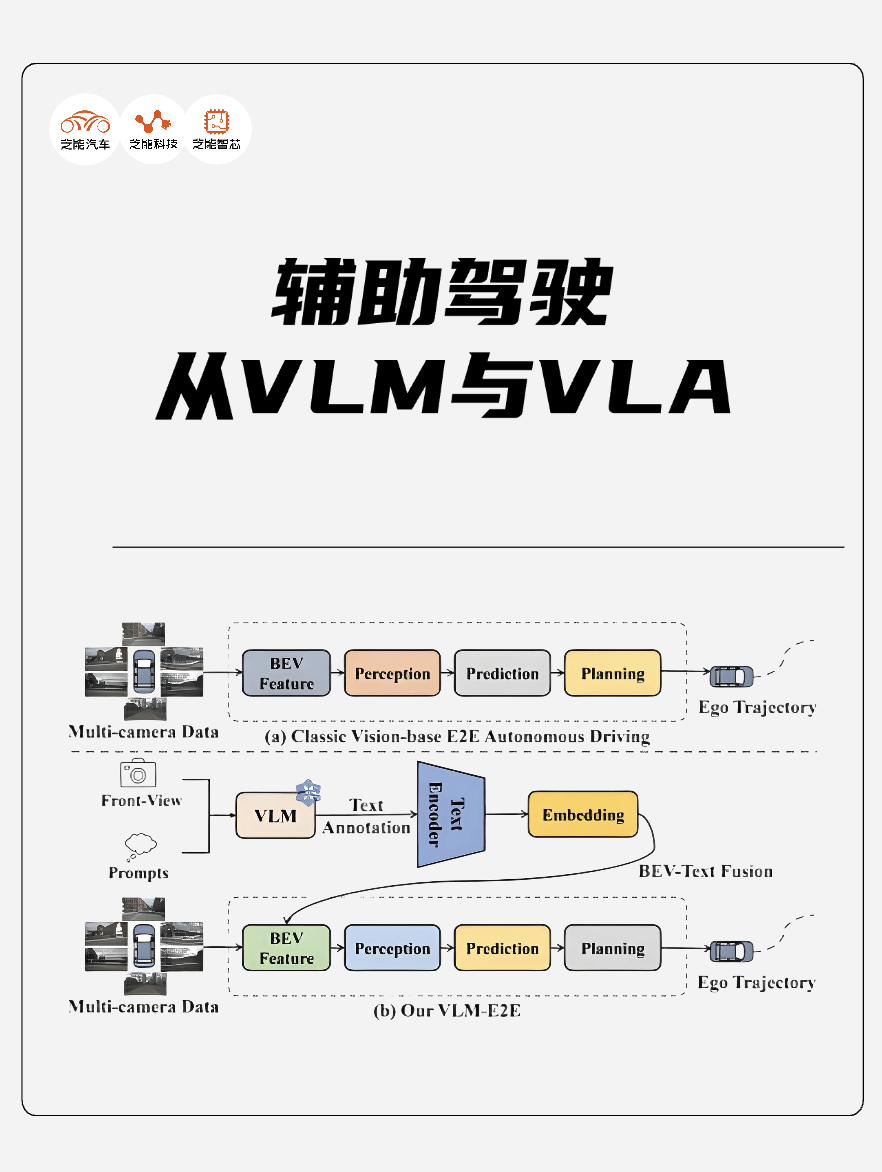

从VLM到VLA

传统的自动驾驶依赖精确的环境建模和规则编程,难以应对现实世界的复杂性与模糊性。

视觉语言模型(VLM)旨在解决这一问题,构建车辆的“认知核心”。

VLM的关键在于能够统一处理来自摄像头、激光雷达等传感器的感知数据,以及交通规则文本、导航信息、自然语言指令等语言数据。通过强大的模型架构,VLM能将这些异构信息编码到共同的特征空间,实现跨模态的关联与推理。

这使得车辆不仅仅是识别障碍物,更能理解场景的深层含义,例如识别特定标志牌并结合交通法规判断当前行为是否合法,或理解用户“靠边停车”的语音指令并规划执行。

● VLM的应用广泛,例如:

◎ 场景语义解析: 识别并理解“潮汐车道”、“施工绕行”等复杂交通语境,生成符合规则的驾驶决策。

◎ 智能人车交互: 理解自然语言指令(如“切换驾驶模式”),或识别视觉兴趣点(如充电桩)并与之关联。

◎ 高阶安全判断: 分析复杂场景(如无保护左转)下潜在风险,辅助决策。

实现这些能力需要强大的计算支持,VLM的出现,让自动驾驶系统从“看清”迈向“看懂”,是实现更高层级自主性的前提。理解世界仅仅是第一步,将理解转化为恰当的行动是自动驾驶的最终目标。

视觉-语言-动作模型(VLA)正是负责这一转化过程,实现从感知、理解到车辆控制的端到端连接。VLA将来自VLM或其他感知模块的环境理解,与车辆的转向、加速、制动等控制指令深度耦合,学习直接从输入到输出的映射。

它形成了一个端到端(End-to-End)的闭环:接收感知和语言输入,内部进行决策,直接输出控制信号。这种模式简化了传统系统的复杂层级,有望提升系统整体响应速度和鲁棒性。

采用Diffusion模型生成驾驶轨迹,并结合ODE采样器优化规划过程,显著提升了轨迹生成质量和复杂路况下的博弈能力,这代表了VLA在行为生成层面的重要进展。

VLM和VLA并非孤立工作,而是紧密协同, VLM理解场景、规则和指令,为VLA提供宏观的驾驶意图和策略指导(例如:根据导航规划变道、识别危险需避让)。

VLA根据VLM的指导和实时的感知信息,生成并执行精确的车辆轨迹和控制动作。VLA的执行结果(成功或失败)可作为反馈,反向优化VLM对场景的理解和决策逻辑,形成持续学习的闭环。

VLA+英伟达Thor,

“空间智能体”

在导入VLA的状态中,理想汽车是很快的。MindVLA(视觉-语言-行动模型)开始向融合空间智能、语言智能和行为智能的物理人工智能迈进。

围绕3D空间理解、高效模型架构、增强逻辑推理、优化轨迹生成、高精度仿真以及卓越泛化能力,让车辆具备感知、思考和自主行动的能力。

● 3D高斯(3D Gaussian)作为核心中间表征,这是其空间智能的基础。

与传统的点云或体素表示相比,3D高斯能同时捕捉物体的几何形状和外观信息,具有更强的语义表达能力和多粒度、多尺度的几何表达灵活性。这使得系统能更全面、高效地感知和理解复杂的3D环境。

结合海量数据上的自监督学习,系统能自动从无标注数据中提取有效的3D特征,大幅提升环境感知的精度和效率,为后续决策奠定坚实基础。

为了在计算资源有限的车端环境运行大规模模型,采用了MoE(Mixture of Experts)架构并引入稀疏注意力(Sparse Attention)。

MoE允许模型在拥有庞大参数量的同时,针对特定输入只激活部分“专家”网络,实现计算的稀疏化,从而在不牺牲模型规模的前提下,维持较高的端侧推理效率。

● 逻辑推理能力是提升的核心,通过训练LLM基座模型学习人类思考模式,并有机结合**“快思考”(实时响应)和“慢思考”(深度推理),模型能根据不同驾驶情境灵活切换决策模式,提升决策的安全性和合理性。

同时,为了最大化利用NVIDIA Drive AGX算力,小词表、投机推理和并行解码等技术,结合英伟达的推理优化,实现了高达7倍的推理效率提升,确保复杂推理也能满足实时性要求。

● 扩散模型(Diffusion Model)优化驾驶轨迹,以生成高质量复杂数据闻名,应用于轨迹生成有望生成更平滑、更自然、更具博弈性的驾驶路径。通过自车行为生成与他车轨迹预测的联合建模,系统能更好地预测交通参与者的行为并进行合理应对。

通过构建人类偏好数据集并引入RLHF(基于人类反馈的强化学习)微调,能更好地对齐人类驾驶习惯,显著提升复杂和极端场景下的安全底线。

NVIDIA Drive AGX平台和生态的支撑,在世界模型、NRE、模型训练加速以及端侧优化部署等领域的技术进展。

最前沿的电子设计资讯

最前沿的电子设计资讯