在下一代座舱芯片支持下,本地部署的大模型开始走入车内,承担起智能座舱的核心任务。相比依赖云端的传统方案,本地模型具备更强的响应能力、隐私保护优势与场景稳定性,正在重塑人车交互的形态。

实际上,端侧AI大模型的实际上车重塑了智能座舱的技术框架,采用本地大模型驱动的智能座舱产品,除了快速响应和多模态交互,不依赖网络的高精度个性化服务,对消费者有哪些体验上的变化,在高通的苏州会议之后,我们准备做一些记录。

从“本地智能”到“主动理解”

本地AI大模型的引入改变了车内计算的基本逻辑。与传统云端方案相比,本地模型最大的特征是其推理过程在终端完成。

这种方式的直接优势,是大幅降低响应延迟,将人机交互的平均等待时间控制在200毫秒(0.2秒)以内,显著改善了智能系统“卡顿”、“误判”的用户体验,响应速度的提升,并非单纯依赖模型压缩,而是源于底层多维协同优化,包括模型结构简化、权重精度削减、芯片适配指令集融合等工程路径。

以舱内语音控制为例,过去语音识别常常要通过云端完成关键字提取、意图识别与指令执行的匹配流程,本地模型则可以在一套计算图中完成这一链路。

例如,在本地完成“打开王老师的车窗”的指令执行,涉及对“王老师”与“车窗”的实体识别、在座位传感器矩阵中定位该乘员、再联动车窗控制逻辑的全过程(之前的座舱只能分主驾、副驾、左后、右后这样的区域),这需要语言理解、用户记忆管理和设备控制三者之间的协同推理,在一个统一模型中实时达成。

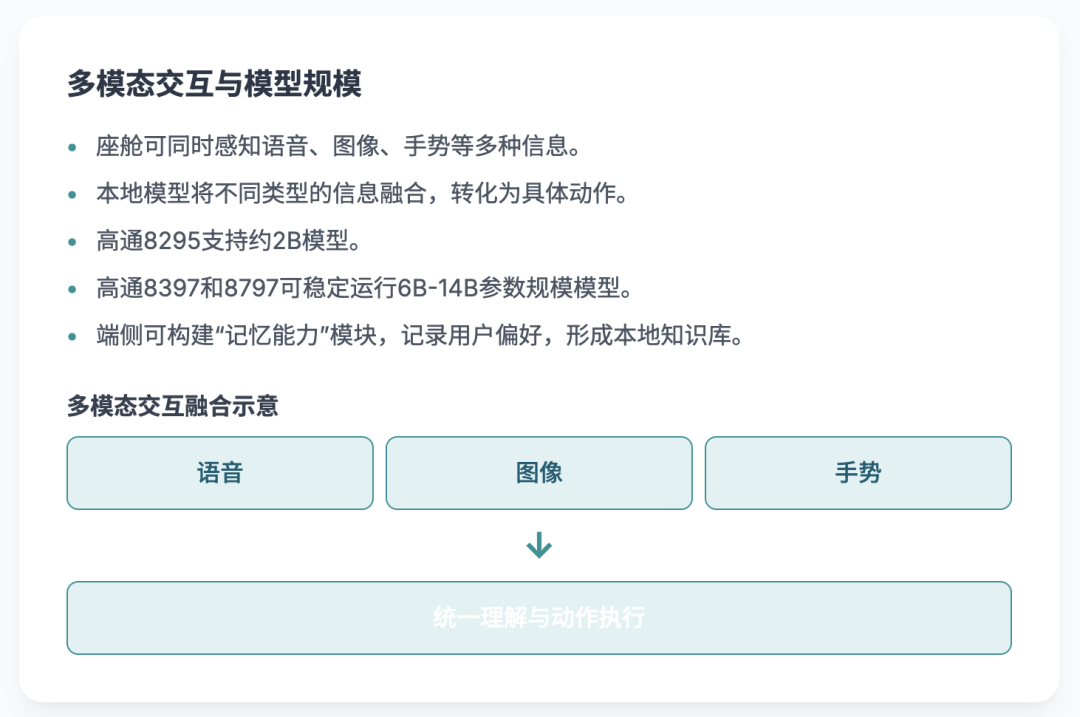

多模态交互也成为本地模型能力评估的重要指标,智能座舱已具备同时感知语音、图像、手势等多种信息的硬件基础,而本地模型的作用是将这些异构信息融合为统一的语义表示,并转化为具体动作。

例如,车外手势开门,要求系统结合视觉检测与语义识别对用户意图做出合理判断;舱内视频解读儿童指令,则需要图像识别与语义对话的深度融合能力,融合不是简单的“堆叠感知通道”,而是通过统一编码器和交叉注意力机制,在时空层面构建语义一致性,这对模型设计的轻量性与泛化能力提出了较高要求。

在目前的高通8295上,可以运行2B左右的模型,而在高通8397和8797上,可以稳定运行6B-14B参数规模的模型,覆盖导航、语音控制、多媒体推荐等任务,端侧还可以构建具备“记忆能力”的模块,用以记录用户行为偏好、常用指令模式,形成本地私有知识图谱。

这些“车内记忆”不依赖云端,可以根据车辆环境与用户状态进行动态调整,实现真正意义上的主动服务而非被动响应。

隐私、稳定与沉浸:

本地模型座舱

本地部署AI模型的另一个核心优势是对用户数据的高度保护。

舱内摄像头、麦克风所采集的图像与音频数据,不再需上传至云端进行处理,而是由本地模型直接完成识别与响应,避免了数据外泄的风险,符合《数据安全法》与GDPR等数据法规要求。这一点在涉及面部识别、儿童图像、乘员行为分析等敏感任务中尤为关键。

由于本地模型对网络连接依赖极低,其稳定性在山区、隧道、弱信号环境下远胜云端方案。

这使得智能座舱的响应能力不再取决于运营商信号质量,而是由车载计算能力主导。这一点在语音控制、视频播放、导航规划等需要即时反馈的场景中,显著提升了连续性和可靠性。

另一个技术演进方向是座舱UI的沉浸式升级。

随着本地GPU计算性能的提升,智能座舱已经开始支持复杂3D建模与动态光影渲染,结合本地大模型的语言驱动能力,车辆状态信息(如胎压、电量)可以以图形方式实时反馈,提升驾驶员感知效率。

例如,用户说“把前左胎压调到2.4”,系统不仅完成设置,还能通过3D图像展示实时胎压状态的变化过程。

在车机作为“第二终端”的趋势下,本地模型还被赋予了跨设备控制的能力。

通过与家庭IoT、手机端任务的协同,本地模型可以控制家电、同步会议、切换媒体,实现“车家一体”的计算闭环。

这里的核心不是简单的远程控制指令,而是模型对上下文的持续理解与任务接管能力。

传统语音助手更像一次性问答机制,而本地大模型则能理解多轮上下文,例如在旅途中主动提醒日程、协调路线与天气变化、甚至调整家中空调温度等。

随着模型复杂度增加,对芯片微架构的适配能力也成为关键一环。

从目前行业发展来看,本地模型已开始倒逼芯片设计向AI原生架构演进,例如优化Transformer类模型在NPU上的推理路径、增加片上缓存容量、降低延迟路径等。模型与芯片之间的共生关系,正在成为下一阶段产业演化的关键基础设施。

本地大模型正在重构车内智能系统的运行范式,不只是“脱离云端”的妥协方案,而是具备独立推理能力的“数字大脑”,在用户隐私、响应速度、交互沉浸感等方面展现出明显优势。

将改变了人车交互的方式,更推动了芯片、系统与算法三位一体的深度融合。智能座舱将逐渐从“助手”角色,向“代理人”角色过渡。

最前沿的电子设计资讯

最前沿的电子设计资讯